Wissen: Digitale Signalverarbeitung, Teil 1

De facto arbeitet heutzutage jeder Musikschaffende mit digitalen Technologien. Die Möglichkeiten sind mittlerweile so ausgereift, dass sich auch mit preisgünstigen Lösungen und ein wenig Know-how effizient arbeiten lässt. Trotzdem sehen sich viele mit Begriffen wie „96 kHz“, „ADAT“, oder „Wordclock“ konfrontiert, ohne deren Bedeutung genau zu kennen. Unsere neue Serie bringt Licht ins Dunkel.

Von Igl Schönwitz

Beim Betrachten des Musikmarkts lässt sich zusehends ein Trend zurück zur analogen Vinyl-Platte erkennen und das nicht nur bei etablierten Künstlern, sondern auch bei noch recht jungen Musikern. In diesem Zusammenhang wird häufig technisch etwas diffus argumentiert, die Schallplatte klänge ja schließlich „besser“, was in dieser Pauschalität so nicht stimmt. Positiv ist aber allemal, dass dieser Trend wieder von einem Bewusstsein für den Wert einer Aufnahme und von einer Wertschätzung für audiophile Qualitäten zeugt. Eine Schallplatte kann gewisse klangliche Vorteile gegenüber einer CD haben – allerdings nur, wenn das heute meist digital produzierte Quellmaterial auch die entsprechende Qualität besitzt. Die digitale Audiotechnik birgt ihre ganz eigenen Problematiken, die sich jedoch mit etwas Grundlagenwissen umschiffen lassen und wodurch sich die Gesamtqualität drastisch erhöhen kann. Wie das geht und was es zu beachten gilt, erläutern wir Ihnen in unserer neuen Serie. Dabei erhalten Sie Einblick in die digitalen Formate und den richtigen Umgang mit der Digitaltechnik, sowohl von theoretischer wie auch praktischer Seite. Die ersten beiden Teile befassen sich mit Grundlagen, Formaten und dem optimalen Studio-Setup. In den darauffolgenden Teilen beleuchten wir schließlich sämtliche praktischen Aspekte.

Fangen wir zunächst ganz von vorne in der Signalkette an: Ein Mikrofon wandelt Schallschwingungen in einen schwachen Wechselstrom um, der in seiner Amplitude der Wellenform des Schallereignisses entspricht – ein Mikrofon und ein Lautsprecher sind daher immer analog. Auf der analogen Ebene werden die so eingefangenen Signale anschließend auf elektronischem Wege weiterverarbeitet und behalten dabei Ihre Wellenform im Wesentlichen bei, oder anders gesagt: Der erzeugte Wechselstrom bleibt erhalten, bis er auf Band aufgezeichnet oder über einen Lautsprecher ausgegeben wird.

Die digitale Audiotechnik arbeitet hingegen mit Computern, alle Bearbeitungen werden errechnet. Da ein Computer nur Zahlen verarbeiten kann, gilt es daher, das analoge Signal in eine Zahlenkette zu verwandeln, wobei dieser Prozess zwangsläufig immer mit Verlusten behaftet ist. Ziel muß es dabei sein, diese Verluste und Ungenauigkeiten so klein zu halten, dass sie in der Praxis nicht wahrgenommen werden können. In der heutigen Audioproduktion wird praktisch ausschließlich das sogenannte PCM-Verfahren (Pulse Code Modulation) zur Wandlung analoger Signale in digitale Formate angewendet. Hierbei wird das analoge Audiosignal in einem bestimmten Zeitraster abgetastet. Als Ergebnis liefern diese Abtastungen Zahlenreihen, mit denen sich schließlich im Computer rechnen lässt. Die dabei entstehenden Dateien werden zumeist im Format AIFF (Audio Interchange File Format) oder WAVE (auch RIFF genannt – Resource Interchange File Format) abgelegt. Qualitativ gibt es zwischen beiden Formaten bei gleicher Auflösung keinen Unterschied. Das AIFF-Format wurde seinerzeit von Apple entwickelt, das WAV-Format hingegen von Microsoft. In den meisten Audioproduktions-Umgebungen (DAW – Digital Audio Workstation) können sie innerhalb eines Projekts übrigens problemlos gleichzeitig verwendet werden. Datenreduzierte Formate wie MP3, aber auch das hochaufgelöste DSD-Format wollen wir aus Platzgründen in dieser Serie nicht behandeln.

Maßgeblich für die Qualität einer A/D-Wandlung im PCM-Verfahren sind die beiden Größen „Wortbreite“ und „Abtastrate“. Sie beschreiben, wie groß die Stufen sind, mit denen das Signal in der Pegel- und Zeitebene abgetastet wird. Stellen Sie sich dazu am Besten ein Koordinaten-System vor: Die Horizontale, also die x-Achse, beschreibt den zeitlichen Verlauf, die Vertikale, mithin die y-Achse, die Amplitude. Je feiner das Raster gewählt wird, desto präziser lässt sich eine darin eingezeichnete analoge Wellenform in x- und y-Koordinaten beschreiben. Beide Größen sind im digitalen Bereich eindeutig definiert, wobei es einige Besonderheiten zu beachten gilt.

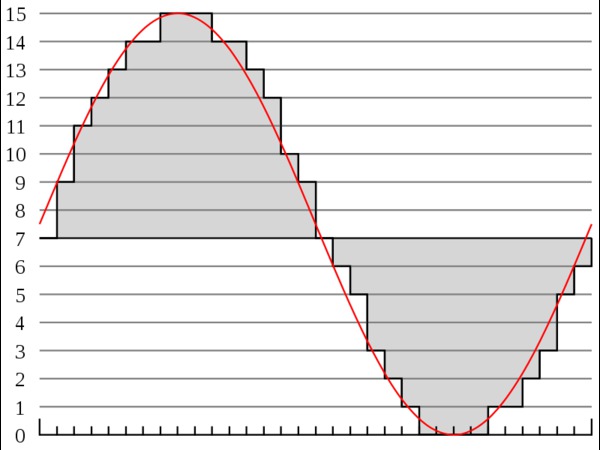

Die Abtastrate, auch im englischen Synonym „Sample Rate“ geläufig, bestimmt die Häufigkeit der Abtastung innerhalb einer bestimmten Zeit.Physikalische Grundlage für die Festlegung der Sample Rate ist das sogenannte Nyquist-Shannon-Abtasttheorem: Claude Shannons Theorem, das sich auf Überlegungen des Physikers Harry Nyquist stützt, besagt, dass eine Funktion, in unserem Falle also eine Schallschwingung, durch eine Reihe von Abtastpunkten eindeutig bestimmt werden kann, wenn die maximale Frequenz der Funktion (=Schallschwingung) bei der Hälfte der Abtastrate liegt.

Es muss also die Formel:

Maximale darzustellende Audiofrequenz ≤ Sample Rate / 2

gelten. Die höchste (Audio-)Frequenz, die sich durch eine bestimmte Abtastrate darstellen läßt, heißt Nyquist-Frequenz – es gilt dementsprechend

f nyquist = ½ f abtast

Übersteigen die Werte der Audio-Frequenz nun die Hälfte der zuvor festgelegten Sample Rate, so kommt es zum sogenannten „Aliasing“: Schwingungen, die zwischen den Abtastpunkten liegen, können nicht richtig erfasst werden und es kommt zu Fehlinterpretationen bei der Rückwandlung. Sie werden im vorgegebenen Rahmen einfach nach unten zu niedrigeren Audio-Frequenzen gebrochen. Es wird, da der Rahmen der maximal darstellbaren Frequenz nicht überschritten werden kann, ein Alias dieses Wertes innerhalb des möglichen Rahmens erzeugt, beispielsweise die Hälfte des tatsächlichen, nicht darstellbaren, Werts. Diese zusätzlich erzeugten Werte machen sich klanglich in Form von Artefakten und Verzerrungen bemerkbar, denn es handelt sich um (Phantom-)Toninformationen, die im Originalsignal nicht vorhanden waren.

Aliasing kann man sich sehr schön anhand alter Westernfilme veranschaulichen: Dort sind häufig Wagenräder von Kutschen zu sehen, die sich immer schneller drehen. Bei zunehmender Geschwindigkeit scheinen die Speichen der Räder plötzlich stehenzubleiben, schließlich dreht sich das Rad wenig später im Bild rückwärts. Die Ursache dafür liegt in der Bild-Frequenz, die beim Film 24 Bilder pro Sekunde beträgt. Diese Frequenz(=Abtastrate) kann die Drehgeschwindigkeit des Rads ab einem bestimmten Punkt nicht mehr erfassen, weshalb sich die dadurch entstehenden Artefakte visuell durch ein rückwärts Drehen der Räder bemerkbar machen. Im Gegensatz zu diesen Phänomenen in Bild- oder Filmtechnik führt Aliasing im Audiobereich immer zu hörbaren Audioinformationen, die im Original nicht vorhanden sind und die Wiedergabe massiv beeinträchtigen. Daher gilt es, Aliasing unter allen Umständen zu vermeiden.

Um Aliasing von vorne herein nicht auftreten zu lassen, ist in der Theorie des Nyquist-Shannon-Theorems bei der Hälfte der Sample Rate ein Tiefpass-Filter mit unendlicher Flankensteilheit vorgesehen. Da ein so steiles Filter in der Praxis jedoch nicht existiert, muß die Sample Rate daher etwas höher gewählt werden als das Doppelte der Nyquist-Frequenz. Üblich in der Musikproduktion, weil CD-Standard, ist bis heute eine Sample Rate von 44,1 Kilohertz, was bedeutet, das pro Sekunde 44.100 Werte erzeugt werden. Laut Nyquist-Shannon-Theorem können somit Frequenzen bis 22,05 Kilohertz erfasst werden. Tatsächlich ist aber, eingedenk der oben erwähnten Filter-Problematik, schon bei 20 Kilohertz Schluss, wenngleich pro Schwingung etwas mehr als zwei Werte erzeugt werden. Trotzdem führt das zu allgemein anerkannt akzeptablen Ergebnissen, nicht zuletzt weil in der Regel auch mit der sogenannten „Oversampling“-Methode gewandelt wird. Mehr dazu gleich.

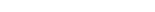

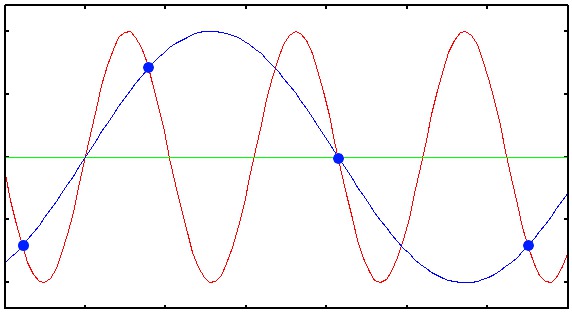

Die zweite maßgebliche Größe, die es digital zu erfassen gilt, ist die Lautstärke des analogen Signals. Dies wird über die sogenannte Wortbreite definiert und in Bit ausgedrückt. Konkret legt die Wortbreite fest, wie viele Stellen die Zahl haben kann, die bei der Digitalisierung erzeugt wird. Üblich sind 16 oder 24 Bit. Dabei gilt: Je mehr Stellen ein Abtastwert besitzt, also je größer die Zahl, desto mehr Dynamik läßt sich darstellen. Ein Beispiel: Die Angabe vier Bit besagt, dass die Zahl vier Stellen mit dem Wert Null oder eins hat. Der maximal darstellbare Wert in diesem Zahlensystem beträgt 2 hoch 4, also 16. In der Graphik auf Seite XX ist zu sehen, dass die Amplitude der dort dargestellten Sinuskurve in sehr grobe Stufen eingeteilt ist. Solch eine grobe Erfassung der Dynamik macht sich akustisch als Rauschen bemerkbar. Dieses Rauschen wird Quantisierungs-Rauschen (siehe unten) genannt und markiert die untere Grenze der digital darstellbaren Dynamik. Die obere Grenze wird durch die maximal mögliche Zahl, in unserem Beispiel also 16, festgelegt. Werte, die darüber hinaus gehen, werden einfach abgeschnitten, da das System sie nicht mehr darstellen kann.

Wie eingangs erwähnt hat die Wortbreite direkt mit der darstellbaren Dynamik zu tun. Mit 16 Bit lassen sich 2 hoch 16, also 65.536 Lautstärke-Werte darstellen, bei 24 Bit sind es bereits 16.777.216. Dabei gilt, dass jedes zusätzliche Bit den Dynamikumfang um etwa sechs Dezibel erhöht, was gleichzeitig einer Verdoppelung des Dynamikumfangs entspricht. Dies bedeutet, daß die Dynamik bei der CD-Auflösung von 16 Bit circa 96 Dezibel beträgt, während bei 24 Bit theoretisch rund 144 Dezibel zur Verfügung stehen. Da kein Mikrofon der Welt 144 Dezibel Dynamik liefert, kann eine Auflösung von 24 Bit für die Aufzeichnung und Speicherung von Audiodaten als hinreichend angesehen werden. Trotzdem existiert in der Praxis auch ein 32-Bit-Format, das in so gut wie allen modernen DAWs anzutreffen ist. Dabei handelt es sich um die Rechentiefe, mit der die Programme arbeiten und nicht um die Wortbreite, was also nicht verwechselt werden darf. Hintergrund: DAWs rechnen deshalb intern in der Regel mit einem 32 Bit Floating-Point-Verfahren, weil bei einer Signalnachbearbeitung und vor allem bei Mischvorgängen auf der digitalen Ebene wesentlich höhere Auflösungen benötigt werden, da die Signale summiert werden. Für das Speichern des fertigen Mixes reichen 24 Bit hingegen völlig aus. Übrigens sind auch die meisten Schnittstellen für „Digital Audio“ dementsprechend nur mit maximal 24 Bit spezifiziert.

Ebenso wie beim Abtasten der Frequenz kann es auch beim digitalen Erfassen der Dynamik zu Fehlern und damit einhergehenden akustischen Artefakten führen. Dies ist bedingt durch die vorhin erwähnte Quantisierung, also quasi die Stufigkeit der digitalen Auflösung (Wortbreite). Eine Wortbreite von 16 Bit besitzt dementsprechend 65.536 Quantisierungsstufen. Definiert man eine Quantisierungsstufe als „q“ so beträgt der maximale Quantisierungsfehler q/2. Die Wahrscheinlichkeit, dass sich der Fehler auf +q/2 oder -q/2 (den Halb-Amplituden) verteilt, ist dabei gleich groß – es entsteht ein weißes Rauschen, das also in allen Frequenzen gleich laut ist. Dabei gilt die Regel: Je höher die Wortbreite, desto geringer das Quantisierungs-Rauschen.Diese Regel gilt jedoch nur für hinreichend große, sprich laute Signale. Im Bereich sehr kleiner Pegel entsteht ein weiteres unschönes Phänomen, die so genannte Quantisierungs-Verzerrung. In diesem Fall ist der Quantisierungsfehler nicht mehr spektral gleich verteilt, sondern ändert sich mit der Frequenz des Nutzsignals – er korreliert mit dem Nutzsignal, was sich durch eine hässliche Verzerrung bemerkbar macht, da sich das Nutzsignal in dem Fall einer Rechteck-Schwingung annähert. Im Gegensatz zur Analogtechnik führen in der digitalen Welt also nicht nur extrem laute, sondern auch extrem leise Signale zu Verzerrungen.

Doch bei allen Problemen und Risiken, die das Digitalisieren analoger Signale birgt, haben die Ingenieure bereits sehr früh Techniken und Strategien ersonnen, um dem wirksam begegnen zu können. Ein kleiner Rückblick: Zu Zeiten der Einführung der CD Anfang der 1980er Jahre wurde die Sample Rate bekanntlich auf 44,1 Kilohertz festgelegt. Diese Frequenz liegt nur knapp über der notwendigen Mindestanforderung von 40 Kilohertz, die laut Nyquist-Shannon theoretisch zur Abbildung des Audiospektrums zwischen 20 Hertz bis 20 Kilohertz erforderlich ist. Höhere Samplingraten hätten signifkant mehr Speicher benötigt, der jedoch seinerzeit äußerst knapp bemessen war. Der genaue Wert von 44,1 Kilohertz ergab sich übrigens aus technischen Normen von VHS-Videorecordern, die damals für die ersten Digitalaufnahmen eingesetzt wurden.

Um die technischen Problematiken und Nachteile dieser relativ niedrigen Sample Rate abzumildern, wurde das sogenannte Oversampling-Verfahren sowohl in der A/D- wie auch der D/A-Wandlung entwickelt. Hierbei wird das Signal mit einem Vielfachen der ursprünglichen Sample Rate abgetastet, sodass zwischen den tatsächlich ermittelten Samplewerten Zwischenwerte entstehen. Bei achtfachem Oversampling und 44,1 Kilohertz Sample Rate ergibt sich so eine resultierende Abtastrate von 352,8 Kilohertz.

Im A/D-Wandler hat das Oversampling den Vorteil, dass das Anti-Aliasingfilter auf der analogen Seite durch die erhöhte Nyquist-Frequenz wesentlich flacher und damit phasenstabiler gestaltet werden kann. Bevor die Abtastrate dann zur Speicherung auf 44,1 Kilohertz herunter gerechnet wird, kann ein weiteres steilflankiges Filter verwendet werden, das dann allerdings bereits auf der digitalen Ebene platzierbar ist, wo es sich wesentlich unproblematischer realisieren lässt.

Im D/A-Wandler werden durch Oversampling hingegen Zwischenwerte interpoliert, die im gespeicherten Originalsignal nicht vorhanden sind. Der Vorteil liegt vor allem darin, dass sich das Frequenzspektrum des Quantisierungsrauschens auf einen bis zur neuen Nyquist-Frequenz erweiterten Bereich ausdehnt, was zu einem niedrigeren Quantisierungsrauschen im Hörbereich führt – der Rauschabstand wird also verbessert.

Im nächsten Teil erörtern wir das Für und Wider hoher Samplingraten, wir lüften das Geheimnis rund um die Wordclock und geben einen Überblick über die wichtigsten digitalen Anschlüsse.

Kommentare

Kategorien

Anzeige

6004

6004